Der EU AI Act – wen soll er schützen und vor wem?

Die aktuelle KI-Landschaft bietet enorme Möglichkeiten, es gibt aber auch zahlreiche Risiken, und auch mit denen müssen wir uns auseinandersetzen. Hier kann ein rechtlicher Rahmen wie der EU AI Act durchaus hilfreich sein.

Risikopotenzial gibt es in vielen Bereichen:

-

- KI kann direkt für kriminelle Zwecke eingesetzt werden – z.B. kann sie genutzt werden um Deep Fakes zu produzieren, Phishing-Mails zu schreiben, sogar um betrügerische Anrufe zu führen

-

- KI kann zu einem Instrument eines übergriffigen Staates werden – oder eine unterwünschte soziale Kontrolle schaffen

-

- KI kann Fehler machen, besonders kritisch in Bereichen wie dem technischen Support, kritischer Infrastruktur, juristischer oder medizinischer Beratung

-

- KI kann angegriffen und manipuliert werden, z.B. mit sogenannten Prompt Injections

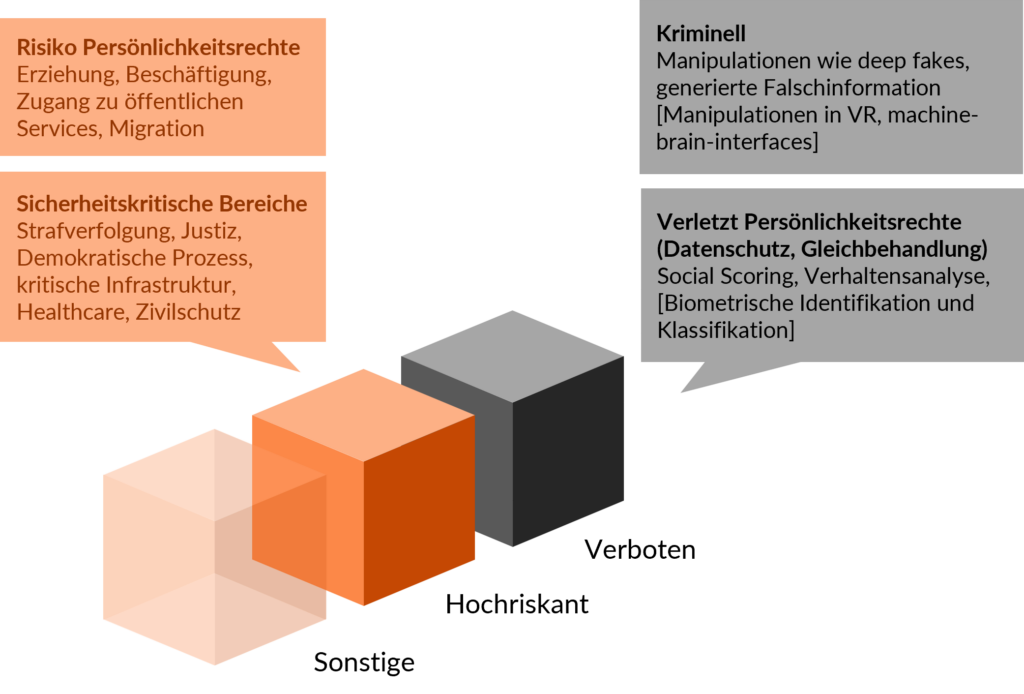

Nicht alle diese Risiken sind gleichermaßen im Fokus des EU AI Acts. Der AI Act legt den Schwerpunkt auf das Schadenspotenzial für Nutzer und Gesellschaft: Wenn die Anwendung kriminellen Zwecken dient oder Persönlichkeitsrechte verletzt, verbietet er sie, wenn Missbrauch nahe liegt oder wenn Fehler gravierende Konsequenzen haben, macht er entsprechende Auflagen. Grob vereinfachend rechts dargestellt.

Man merkt es dem AI Act an, dass er zu weiten Teilen vor dem Siegeszug der Sprachmodelle entstanden ist. Grundsätzlich ist das nicht kritisch, die Regelung sollte ja neutral gegenüber Technologie sein. Aber das führt u.a. dazu, dass zwar alle möglichen Rollen definiert sind, aber ganz viele Pflichten bei den Anbietern liegen, in der Welt der Sprachmodelle also den Foundation-Model-Herstellern wie OpenAI, Google, Meta etc. Viele der Risiken hängen aber eng mit dem Einsatz der Modelle in einer bestimmten Anwendung zusammen und können seitens der Foundation-Model-Hersteller nicht ausgeschlossen werden. Das können nur die Unternehmen, die innerhalb ihrer KI-Anwendungen Sprachmodelle einsetzen (im EU-AI-Act-Sprech „Bereitsteller“), die werden aber vom AI Act deutlich weniger in die Pflicht genommen.

Ähnlich sieht es mit der Risiko-Klassifikation aus: Offenbar konnte sich zum Zeitpunkt der Entstehung des AI Acts verständlicherweise niemand vorstellen, dass eine KI medizinische Beratung oder Rechtsberatung anbieten würde.

Andererseits sind viele Risiken auch gar nicht Gegenstand des AI Acts. Der AI Act will die Welt vor unserer KI-Anwendung schützen. Wenn wir keine Anwendung zur Überwachung-, Social-Scoring, Generierung von Deep Fakes etc. vorhaben, dann müssen wir uns viel mehr damit auseinandersetzen, unsere KI-Anwendung vor der Welt zu schützen – und vor sich selbst:

-

- Wenn wir z.B. in unserem Unternehmen

-

- unseren Mitarbeitern einen virtuellen Assistenten zur Verfügung stellen, der bei Recherche, Schreiben von Reports und Beantwortung von E-Mails hilft, und ein Externer, z.B. ein Lieferant von Informationen bringt den Assistenten mit Hilfe einer Prompt Injection dazu, ihm vertrauliche Information zu schicken

-

- Wenn unsere KI, die Bewerbungen vorsortiert, von Bewerbern manipuliert wird, die mit „white-fonting“ Anweisungen an die KI in ihre Lebensläufe platziert

-

- Wenn wir als ein Unternehmen der Haushaltselektronik unseren potenziellen Kunden mit einem Sales-Bot rund um die Uhr Beratung anbieten, der aber anfängt unsere Geschäftsinteressen zu verletzten indem er absurde Rabatte verspricht, Konkurrenzprodukte anbietet und Kunden vertreibt.

Versuch einer Systematik

Eine Dimension der Unterscheidung liefert der AI Act: Wie sehr liegt das Verursachen von Schäden schon in der Intention der Anwendung

- Die Anwendung kann böswillig sein, schon der Zweck der Anwendung kann kriminell sein oder die Verletzung von Persönlichkeitsrechten implizieren

- Die Anwendung kann anfällig für Verletzung der Persönlichkeitsrechte sein, wenn sie sensible Daten erhebt oder Entscheidungen über Menschen fällt

- Die Anwendung kann gutwillig sein, d.h. wenn Schäden entstehen, dann durch Fehler der KI

Eine weitere Dimension ist ebenfalls im AI Act verarbeitet, das Schadenspotenzial: z.B. werden Sicherheitskomponenten kritischer Infrastruktur direkt erwähnt (medizinische Beratung interessanterweise nicht, vermutlich weil das Feld vor dem Siegeszug von ChatGPT und Co. noch zu sehr Science Fiction war).

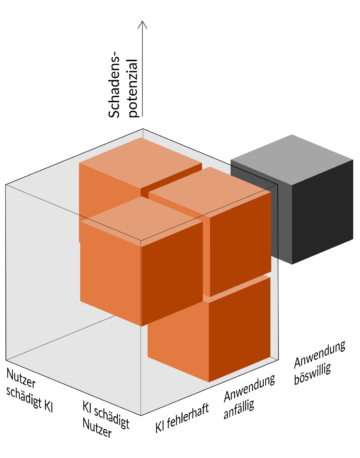

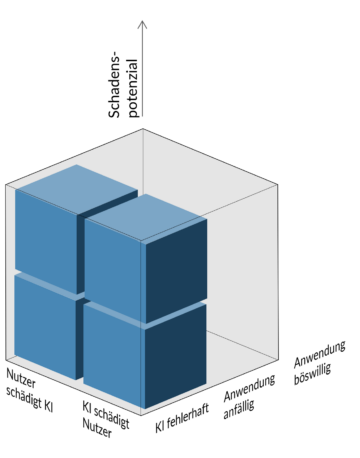

Wenn wir die aktuelle Verbreitung von Sprachmodellen und die damit verbundenen Business-Risiken berücksichtigen wollen, müssen wir eine weitere Unterscheidung hinzufügen:

Wer schädigt eigentlich wen? Die KI den Nutzer? Der Nutzer die KI? Wobei wir für KI in beiden Fällen den Betreiber einsetzen können: der wird im Falle eines Cyberangriffs oder Betrugs geschädigt und der ist umgekehrt auch verantwortlich für die Schäden die seine KI verursacht (Siehe z.B. das Urteil gegen Air Canada, deren AI-Bot einem Fluggast einen falschen Hinweisen zu den Tarifen gab).

In dieser Systematik (Intention der Anwendung, Schadenspotenzial, wer schädigt wen?) macht der AI Act Aussagen über die rechts abgedeckten Bereiche.

Das bedeutet aber: Auch wenn wir alle Auflagen des AI Act erfüllen, haben noch nicht viel für den Schutz unseres Business getan.

Klaus Reichenberger